🌟 팀 성과

- ✔ KoBART 기반의 baseline 성능을 안정적으로 구현하고, 다양한 하이퍼파라미터 실험과 tokenizer 설정 최적화를 통해 평균 ROUGE 점수 향상

- ✔ 팀원 간 역할을 나누어 EDA, 전처리, 모델 학습, 결과 분석 등 각 단계에서 책임감을 가지고 협업

- ✔ KoBART, Gemma 등 다양한 접근 방식을 실험하며, open model의 한계와 가능성을 비교 분석

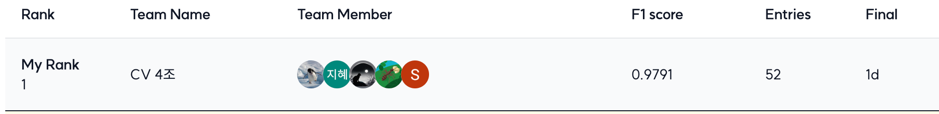

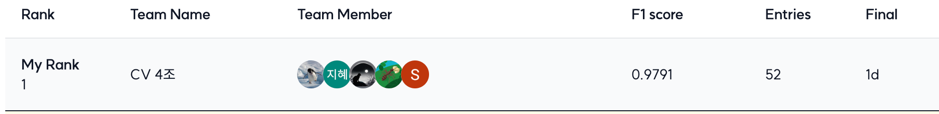

- 최종 리더보드 기준 3위 달성

본 프로젝트는 일상생활에서 이루어지는 대화를 바탕으로 핵심 내용을 요약하는 AI 모델을 개발하는 것을 목표로 합니다. 회의, 직장, 여행, 여가, 쇼핑 등 다양한 주제의 대화문을 요약하여, 통화 비서나 회의록 요약 등의 실제 서비스에 활용할 수 있는 모델을 구축합니다.

기간: 2025년 3월 12일 ~ 2025년 3월 24일

인원: 총 5명

AutoTokenizer 기반 전처리 구조를 설계하였으며, 학습 및 추론에 필요한 설정값을 YAML 기반으로 분리하여 유지보수성을 높였습니다.

KoBART 외에도 GPT-4o, Solar-Pro 등 최신 언어 모델을 함께 실험하여 다양한 요약 방식의 효과를 비교 분석하였습니다.

- 문제 배경: KoBART 모델의 입력 최대 길이 제한(512 토큰)을 초과하는 대화문이 존재하여 학습 시 오류가 발생했습니다. 특히 평균 20턴, 최대 60턴으로 구성된 대화에서 긴 발화가 많아 token overflow가 자주 발생했습니다.

- 해결 방법: tokenizer 설정 시 `truncation=True` 옵션을 명시하고, `encoder_max_len` 값을 적절히 조정하여 모델이 수용 가능한 범위 내에서 입력을 자르는 방식으로 해결했습니다. 다만 이로 인해 중요한 발화 일부가 잘릴 가능성을 고려하여, dialogue length 분포를 기반으로 최적의 max length를 탐색했습니다.

- 문제 배경: 모델의 성능이 좋아졌는지를 판단하기 위한 기준이 명확하지 않았습니다. Rouge 점수는 표준 지표이지만, 정답 요약이 단일 문장으로 제공되어 있고 생성 가능한 요약의 표현이 다양한 상황에서 이 점수만으로 성능을 단정하기 어려웠습니다.

- 해결 방법: Rouge-1, Rouge-2, Rouge-L 등 다수의 지표를 함께 사용하고, 정량 평가 외에도 직접 요약문을 확인하며 정성적으로 비교하는 과정을 병행했습니다. 학습용 데이터가 존재하지 않는 테스트 환경이었기 때문에 wandb 등 실험 관리 도구를 사용할 수는 없었으며, 대신 다양한 출력 예시를 수집하고 직접 비교·분석하여 모델 성능을 평가했습니다.

요약 모델의 성능은 전처리, 구조, 학습 전략, 실험 설계가 종합적으로 작용한다는 것을 배웠습니다. 다양한 조건에서의 실험과 그 결과를 추적·관리하는 경험을 통해 실무에서도 재현 가능한 파이프라인의 중요성을 체감했습니다.

또한, LLM의 성능이 실제로 향상되었는지를 정량적으로 평가하기가 쉽지 않다는 점도 깨달았습니다. Rouge와 같은 지표는 정답과의 유사도를 수치화하지만, 요약이라는 작업의 특성상 다양한 정답이 가능하기 때문에 평가 지표로서의 한계가 존재합니다. 결과적으로 모델 개선이 의미 있는지 판단하기 위해선 정량적 지표 외에도 사람 중심의 정성적 판단과 예시 비교가 함께 이루어져야 함을 느꼈습니다.

이 과정에서 Huggingface 플랫폼이 매우 유용하다는 것도 알게 되었습니다. Huggingface는 다양한 사전 학습 모델을 제공할 뿐만 아니라, Tokenizer, Trainer, Metrics 등의 모듈화된 도구를 제공하여 실험과 재현성을 높여줍니다. 특히 `transformers` 라이브러리는 PyTorch 및 TensorFlow 기반 모델을 손쉽게 불러오고 fine-tuning 할 수 있도록 도와줘, NLP 연구와 실무 모두에서 중요한 역할을 한다는 것을 실감했습니다.